- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:44.

- Zadnja izmjena 2025-01-22 17:19.

Dok Spark podržava utovar datoteke iz lokalni sistem datoteka, zahtijeva da datoteke dostupni su na istoj putanji na svim čvorovima u vašem klasteru. Neki mrežni sistemi datoteka, kao što su NFS, AFS i MapR-ov NFS sloj, izloženi su korisniku kao običan sistem datoteka.

Nakon toga, neko se također može pitati, kako da pokrenem spark u lokalnom načinu?

U lokalni način rada , iskra poslovi trči na jednoj mašini, a izvode se paralelno koristeći multi-threading: ovo ograničava paralelizam na (najviše) broj jezgara u vašoj mašini. To trči poslovi u lokalni način rada , morate prvo rezervirati mašinu preko SLURM-a u interaktivnom način rada i prijavite se na njega.

Pored gore navedenog, šta je SC textFile? textFile je metoda org. apache. SparkContext razred koji glasi a tekstualnu datoteku iz HDFS-a, lokalnog sistema datoteka (dostupno na svim čvorovima) ili bilo kojeg URI-ja sistema datoteka koji podržava Hadoop i vrati ga kao RDD nizova.

S tim u vezi, šta je spark datoteka?

The Spark File je dokument u kojem čuvate svu svoju kreativnu dobrotu. Definisao ga je autor Stephen Johnson. Dakle, umjesto da zapisujete bilješke na Post-it® usred noći ili posvećujete različite časopise idejama, stavljate sve svoje koncepte u jedan fajl.

Šta je paralelna iskra prikupljanja?

Kasnije ćemo opisati operacije na distribuiranim skupovima podataka. Paralelizovane kolekcije kreiraju se pozivanjem JavaSparkContext 's paralelizirati metoda na postojećoj Kolekcija u vašem programu drajvera. Elementi zbirka kopiraju se kako bi se formirao distribuirani skup podataka kojim se može raditi paralelno.

Preporučuje se:

Može li Python čitati ZIP datoteke?

Za rad na zip datotekama koristeći python, koristit ćemo ugrađeni python modul koji se zove zipfile. print ('Gotovo!' ZipFile je klasa zipfile modula za čitanje i pisanje zip datoteka. Ovdje uvozimo samo klasu ZipFile iz zipfile modula

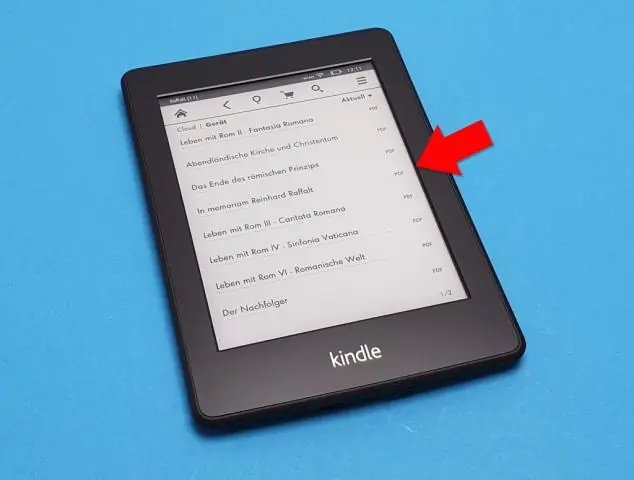

Može li finale čitati PDF datoteke?

Profesionalni savjet: Također možete otvoriti datoteku u Finale-u tako što ćete odabrati datoteku u svom tražilu i kliknuti desnim klikom. Zatim odaberite "Otvori sa…" i odaberite Finale na programskoj traci. Čestitamo! Uspješno ste uvezli PDF datoteku u Finale koristećiScanScore

Može li nook čitati PDF datoteke?

Dokumenti koje možete dodati u Nookin uključuju PDF-ove, koji mogu biti knjige ili drugi kraći dokumenti. PDF-ovi na Nook-u mogu se čitati kao i svaka druga kupljena knjiga, a možete sinhronizirati uređaj, kopirajući dokumente sa svog računara u Nook. Dvaput kliknite na fasciklu “Knjige” ili “Dokumenti” na disku vašeg Nook-a

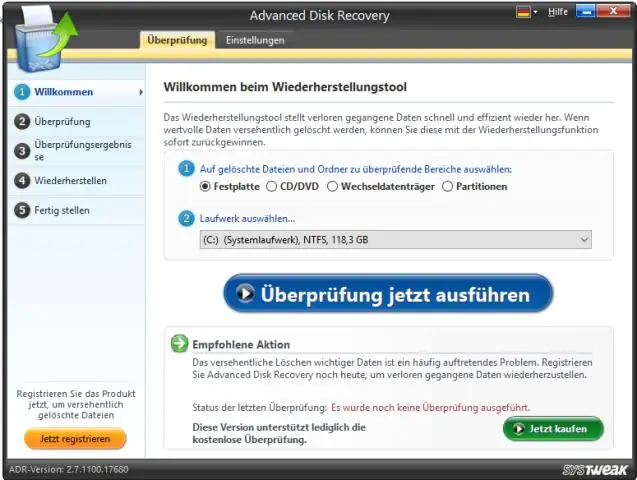

Može li Windows 10 čitati neobrađene datoteke?

Windows 10 se ne isporučuje s izvornom podrškom za pregled neobrađenih datoteka slika, što znači da korisnici ne mogu vidjeti sličice ili metapodatke u aplikaciji Fotografije ili Windows File Explorer. Međutim, Microsoft ima rješenje za fotografe kojima je ova mogućnost potrebna, a zove se proširenje sirove slike

Može li Windows čitati HEIC datoteke?

HEIF Image Extension omogućava Windows 10 uređajima da čitaju i pišu datoteke koje koriste HighEfficiency Image File (HEIF) format. Takvi fajlovi mogu imati a. heic or. Ako paket HEVC Video Extensions nije instaliran, HEIF Image Extension neće moći čitati ili pisati