- Autor Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:44.

- Zadnja izmjena 2025-01-22 17:20.

Laički rečeno, self - pažnju mehanizam omogućava ulazima da međusobno komuniciraju (“ self ”) i saznajte kome bi trebali platiti više pažnju da (“ pažnju ”). Izlazi su agregati ovih interakcija i pažnju rezultati.

Takođe, šta je pažnja prema sebi?

Self - pažnju , koji se ponekad naziva intra- pažnju je pažnju mehanizam koji povezuje različite pozicije jedne sekvence kako bi se izračunala reprezentacija niza.

Takođe, šta je samopažnja u dubokom učenju? Prvo, hajde da definišemo šta “ self - Pažnja ” je. Cheng i ostali, u svom radu pod nazivom „Mreže dugotrajne memorije za Mašina Čitanje”, definisano self - Pažnja kao mehanizam povezivanja različitih pozicija jedne sekvence ili rečenice kako bi se dobila živopisnija reprezentacija.

Što se toga tiče, šta je mehanizam pažnje?

Mehanizam pažnje omogućava dekoderu da vodi računa o različitim dijelovima izvorne rečenice u svakom koraku generiranja izlaza. Umjesto da kodiramo ulaznu sekvencu u jedan fiksni vektor konteksta, pustili smo model da nauči kako da generiše kontekstualni vektor za svaki izlazni vremenski korak.

Šta je model zasnovan na pažnji?

Pažnja - zasnovani modeli pripadaju klasi modeli obično se naziva sekvenca do sekvence modeli . Cilj ovih modeli , kao što ime sugerira, da proizvede izlaznu sekvencu zadanu ulaznu sekvencu koja je, općenito, različite dužine.

Preporučuje se:

Kako funkcioniše electrum novčanik?

Šifrovana datoteka novčanika koja sadrži vaše privatne ključeve zaštićena je lozinkom. Electrum novčanik koristi seed frazu kao rezervnu meru. Ovo vas štiti ako izgubite svoj privatni ključ ili je uređaj na kojem je instaliran Electrum izgubljen ili ukraden. Electrum ne preuzima nikakvu skriptu

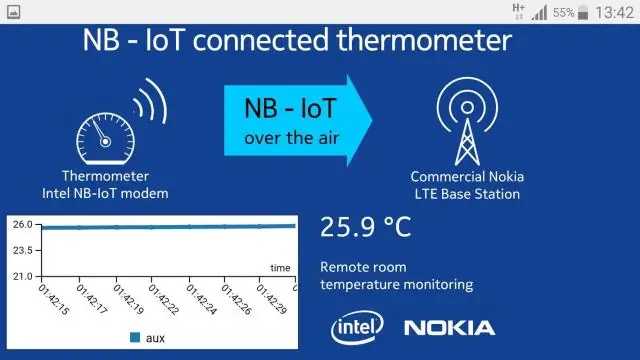

Kako funkcioniše NB IoT?

NB-IoT je tehnologija koja omogućava velikom broju uređaja slanje podataka tamo gdje nema standardne pokrivenosti mobilnom mrežom. Koristi licencirani frekvencijski spektar gdje nema smetnji s drugim uređajima što garantuje pouzdaniji prijenos podataka

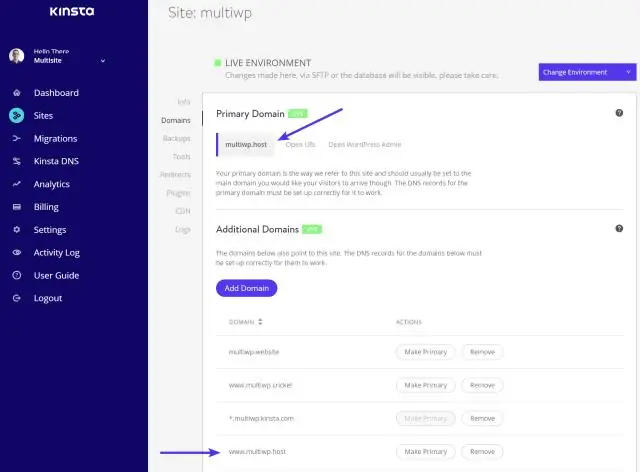

Kako funkcioniše WordPress multisite?

WordPress Multisite je verzija WordPress-a koja vam omogućava da pokrenete više stranica sa jednom instalacijom WordPress-a. Omogućava pokretanje mreže web lokacija pod jednom kontrolnom pločom WordPress. Možete upravljati svime, uključujući broj lokacija, funkcija, tema i korisničkih uloga

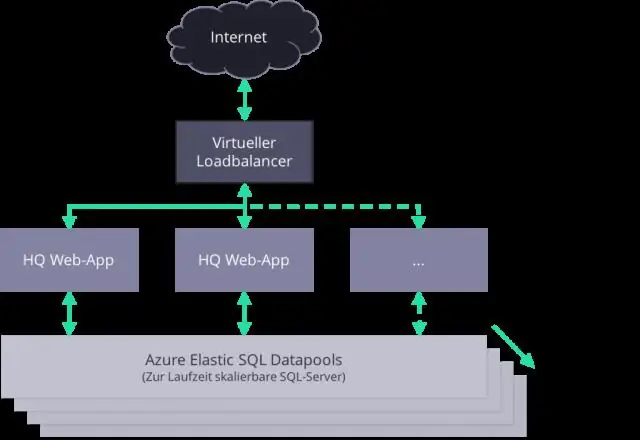

Kako funkcioniše ECS automatsko skaliranje?

Automatsko skaliranje je mogućnost automatskog povećanja ili smanjenja željenog broja zadataka u vašoj Amazon ECS usluzi. Amazon ECS koristi uslugu automatskog skaliranja aplikacija za pružanje ove funkcionalnosti. Za više informacija pogledajte Korisničko uputstvo za automatsko skaliranje aplikacije

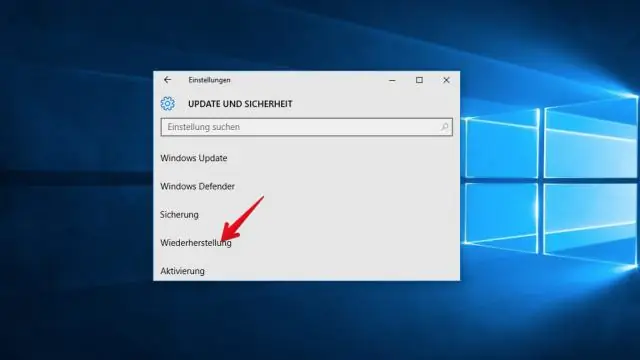

Šta je Windows Deployment Services i kako funkcioniše?

Windows Deployment Services je uloga servera koja administratorima daje mogućnost daljinskog postavljanja Windows operativnih sistema. WDS se može koristiti za mrežne instalacije za postavljanje novih računara tako da administratori ne moraju direktno instalirati svaki operativni sistem (OS)