- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:44.

- Zadnja izmjena 2025-01-22 17:19.

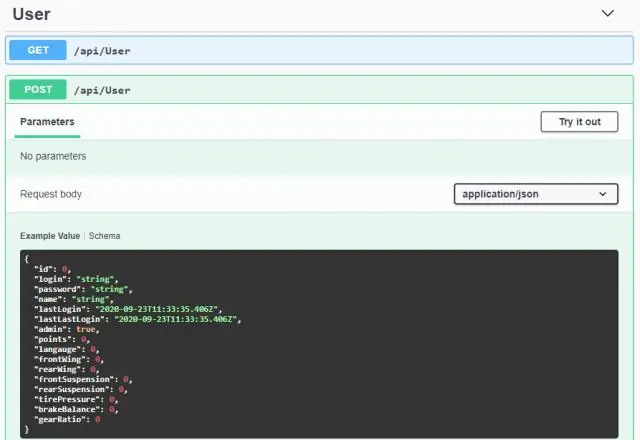

Ne, nećeš treba naučiti Hadoop to learnSpark . Spark bio je samostalan projekat. Ali nakon YARNand Hadoop 2.0, Spark postao popularan jer Spark može raditi na vrhu HDFS-a zajedno s drugim Hadoop komponente. Hadoop je okvir u kojem pišete posaoMapReduce nasljeđivanjem Java klasa.

Slično tome, šta je bolje naučiti Spark ili Hadoop?

Prva i glavna razlika je kapacitet RAM-a i njegovo korištenje. Spark koristi više Memorija slučajnog pristupa nego Hadoop , ali "jede" manje količine internetske ili disk memorije, pa ako je koristite Hadoop , to je bolje pronaći moćnu mašinu sa velikom internom memorijom.

Drugo, da li je Hadoop lako naučiti? Hadoop programiranje je lakše za ljude sa SQL vještinama - zahvaljujući Pig and Hive. Učenici ili profesionalci bez ikakvog znanja programiranja, sa samo osnovnim znanjem SQL-a, mogu savladati Hadoop putem sveobuhvatnog praktičnog rada Hadoop obuku ako imaju žara i volje za to naučiti.

Također je postavljeno pitanje koliko će vremena trebati da se nauči Hadoop?

otprilike 3-4 mjeseca

Da li iskra zamjenjuje Hadoop?

Spark nikada ne može biti a zamjena za Hadoop ! Spark je procesor za obradu koji funkcionira na vrhu Hadoop ekosistema. Kao što je prikazano u gornjoj arhitekturi, Spark dolazi umjesto MapReduce u Hadoop ekosistema. Postoje i druge komponente u Hadoop arhitektura za obradu podataka poput Pig and Hive.

Preporučuje se:

Je li teško naučiti sajber sigurnost?

Stepen kibernetičke sigurnosti može biti težak u poređenju s drugim programima, ali obično ne zahtijeva viši nivo matematike ili intenzivne laboratorije ili praktične vježbe, što može učiniti kurseve mnogo lakšim za upravljanje

Gdje mogu naučiti Linux?

Svi koji žele naučiti Linux mogu koristiti ove besplatne kurseve, ali su pogodniji za programere, QA, sistemske administratore i programere. Osnove Linuxa za IT profesionalce. Naučite Linux komandnu liniju: osnovne naredbe. Red Hat Enterprise Linux tehnički pregled. Linux tutorijali i projekti (besplatno)

Trebam li naučiti ASP NET core?

ASP.NET Core je najnovija verzija i veoma je slična prethodnoj verziji MVC-a kao što je MVC 5, MVC 4. Tako da možete brzo naučiti CORE za 1 mjesec i početi ga koristiti u svojim projektima. Toplo vam preporučujem da se odlučite za CORE jer nikad ne znate kada Microsoft može zaustaviti podršku prethodnih verzija MVC-a

Koju vrstu kodiranja trebam naučiti?

Python i JavaScript su laki za učenje i stoga se smatraju najboljim programskim jezicima za učenje za početnike. Štoviše, oba također pružaju ogromnu tržišnu priliku. Stoga, oni koji traže promjenu posla mogu razmisliti i o tome da ih nauče. Java i PHP su popularni u korporativnom svijetu

Što je bolje naučiti Spark ili Hadoop?

Ne, nije obavezno da prvo naučite Hadoop da biste naučili Spark, ali osnovno znanje o Hadoop-u i HDFS-u će dodati prednost vašem učenju Spark-a. Spark je tehnologija u nastajanju i žurka je na tržištu. Learning Spark će biti od koristi za vašu karijeru jer su Spark profesionalci preferiraniji u industriji