Sadržaj:

- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:44.

- Zadnja izmjena 2025-01-22 17:19.

Skupiti (Akcija) - Vrati sve elemente skupa podataka kao niz u programu drajvera. Ovo je obično korisno nakon filtera ili druge operacije koja vraća dovoljno mali podskup podataka.

Na ovaj način, šta je PySpark?

PySpark Programiranje. PySpark je saradnja Apache Spark-a i Pythona. Apache Spark je klaster-računarski okvir otvorenog koda, izgrađen oko brzine, jednostavnosti upotrebe i analize strujanja, dok je Python programski jezik opšte namjene, visokog nivoa.

Takođe, šta je mapa u PySparku? Spark Mapa Transformacija. A mapa je operacija transformacije u Apache Spark-u. Primjenjuje se na svaki element RDD-a i vraća rezultat kao novi RDD. Mapa transformiše RDD dužine N u drugi RDD dužine N. Ulazni i izlazni RDD će obično imati isti broj zapisa.

Na ovaj način, šta je SparkContext u PySparku?

PySpark - SparkContext . Oglasi. SparkContext je ulazna tačka za bilo koji iskra funkcionalnost. Kada pokrenemo bilo koji Spark aplikacije, pokreće se program drajver koji ima glavnu funkciju i vaš SparkContext ovdje se inicira. Program drajvera zatim izvodi operacije unutar izvršilaca na radnim čvorovima.

Kako mogu provjeriti verziju PySparka?

2 odgovora

- Otvorite Spark shell Terminal i unesite komandu.

- sc.version Ili spark-submit --version.

- Najlakši način je da jednostavno pokrenete “spark-shell” u komandnoj liniji. Prikazaće se.

- trenutna aktivna verzija Spark-a.

Preporučuje se:

Šta je w3c šta je Whatwg?

Radna grupa za tehnologiju primjene web hiperteksta (WHATWG) je zajednica ljudi zainteresiranih za razvoj HTML-a i srodnih tehnologija. WHATWG su osnovali pojedinci iz Apple Inc., Mozilla Foundation i Opera Software, vodećih dobavljača web pretraživača, 2004

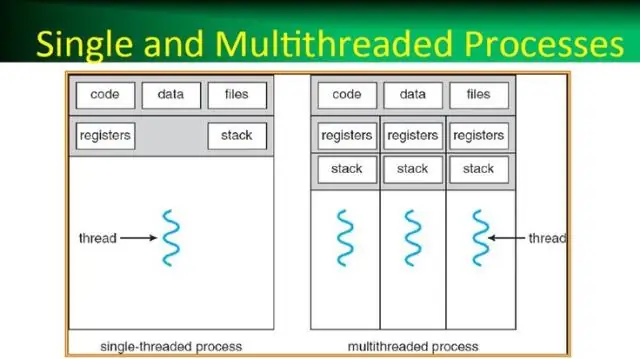

Šta je proces u operativnom sistemu šta je nit u operativnom sistemu?

Proces, najjednostavnije rečeno, je izvršni program. Jedna ili više niti se pokreću u kontekstu procesa. Nit je osnovna jedinica kojoj operativni sistem dodeljuje procesorsko vreme. Pul niti se prvenstveno koristi za smanjenje broja niti aplikacija i pružanje upravljanja radničkim nitima

Šta je personalni računar Šta je skraćenica?

PC - Ovo je skraćenica za personalni računar

Šta je heuristika reprezentativnosti Šta je heuristika dostupnosti?

Heuristika dostupnosti je mentalna prečica koja nam pomaže da donesemo odluku na osnovu toga koliko je lako nešto prisjetiti. Heuristika reprezentativnosti je mentalna prečica koja nam pomaže da donesemo odluku uspoređujući informacije s našim mentalnim prototipima

Kako da napravim PySpark DataFrame sa liste?

Pratim ove korake za kreiranje DataFrame-a iz liste torki: Kreirajte listu torki. Svaki tuple sadrži ime osobe s godinama. Kreirajte RDD sa gornje liste. Pretvorite svaki tuple u red. Kreirajte DataFrame primjenom createDataFrame na RDD uz pomoć sqlContext